原文链接:https://mbd.baidu.com/newspage/data/landingsuper?rs=3222100401&ruk=8MVN0ObRzpLf_xb_Ge1TDQ&pageType=1&isBdboxFrom=1&urlext=%7B%22cuid%22%3A%22guvK80aHvtlO82tzliS_8liIS8lJ8HuPliviig83HuKs0qqSB%22%7D&sid_for_share=57654_2&context=%7B%22nid%22%3A%22news_9347872671747780807%22,%22sourceFrom%22%3A%22bjh%22%7D

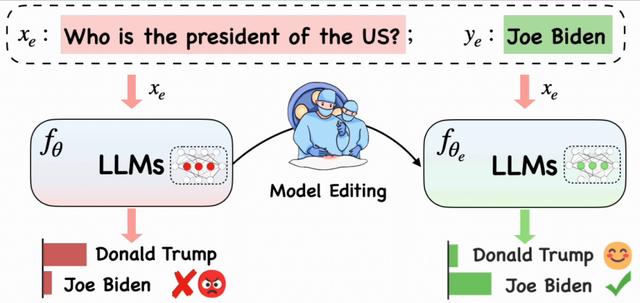

大型语言模型(LLMs)革新了现代自然语言处理(NLP),显著提升了各种任务性能。

然而,现已部署的 LLMs 依然会受到知识截断和谬误问题的限制。例如,ChatGPT 和 LlaMA 等

LLMs 仅具备截至训练最后时点的信息,也可能会因预训练数据中的偏见和差异生成不准确或误导性的输出。因此,高效更新 LLMs 的参数化知识进而调整特定行为,变得至关重要。

尽管微调和参数高效微调可以修改 LLMs,但成本较高,还可能导致 LLMs 失去预训练所得能力,并且其修改也总能泛化到相关输入。另一种方法是,使用手动编写或检索的提示影响 LLMs 的输出,但这类方法没有参数更新,可靠性不足。

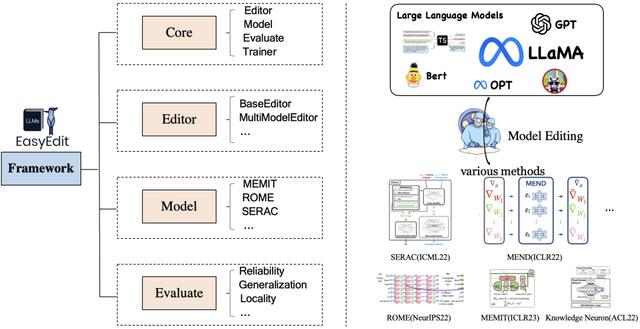

为了解决上述问题,浙江大学和东海实验室的研究团队提出了一个易于使用的 LLMs 知识编辑框架——EasyEdit,该框架支持各种知识编辑方法,且可以轻松应用于众多 LLMs,如 T5、GPT-J 和 LlaMA 等。

相关研究论文以“EasyEdit: An Easy-to-use Knowledge Editing Framework for Large Language Models”为题,已发表在预印本网站 arXiv 上。相关数据集、Google Colab 教程和文档也已发布在 GitHub 上。

论文链接:

https://arxiv.org/abs/2308.07269

GitHub 地址:

https://github.com/zjunlp/EasyEdit

为了使不相关输入的影响最小化,并迅速有效地修改 LLMs 的行为,一种可行的解决方案是知识编辑。关于 LLMs 的知识编辑研究在各种任务和设置下取得显著进展,包括 Memory based、Meta-learning 和 Locate-Then-Edit 三类方法。

然而,目前关于 LLMs 知识编辑的研究在实现和任务设置上的差异妨碍了知识编辑统一和综合框架的发展。值得注意的是,这种复杂性阻碍了不同方法之间有效性和可行性的直接比较,也使得创建新的知识编辑方法变得复杂。

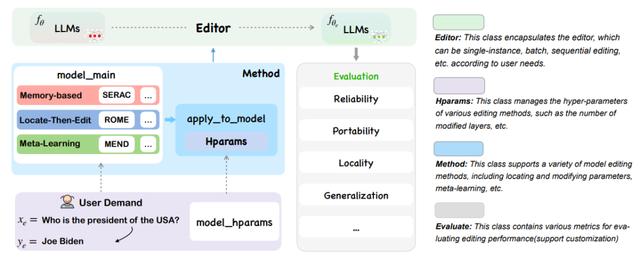

据介绍,EasyEdit 框架整合了各种编辑技术,支持在不同 LLMs 之间自由组合模块。通过统一的框架和接口,EasyEdit 能使用户迅速理解并应用包含在该框架中的主流知识编辑方法。EasyEdit 具有统一的 Editor、Method 和 Evaluate 框架,分别代表编辑场景、编辑技术和评估方法。

此外,EasyEdit 还提供了五个评估编辑方法性能的关键指标,包括可靠性(Reliability)、泛化性(Generalization)、局部性(Locality)、可移植性(Portability)和效率(Efficiency)。

为验证知识编辑在 LLMs 中的应用潜力,研究团队选用了参数庞大的 LlaMA 2 模型,并利用 ZsRE 数据集(QA 数据集)来测试知识编辑将大量一般事实关联整合进模型的能力。测试结果证明,EasyEdit 在可靠性和泛化性方面超越了传统的微调方法。

据论文描述,作为一个易于使用的 LLMs 知识编辑框架,EasyEdit 支持许多尖端方法和不同种类的 LLMs。通过一种可控且有针对性的方式对 LLMs 进行编辑,该技术可能为各种自然语言处理任务中的知识增强和适应带来新的可能。

未来,该研究团队将继续把先进的编辑技术、创新特性(如编辑个性)和新的编辑目标(如针对多模态 LLMs 的知识编辑)融入 EasyEdit 中,从而促进进一步的研究,并在自然语言处理领域激发新的思想。