原文链接:https://mp.weixin.qq.com/s/h8mtOFeyS1WTqJRcfv9lhQ

![]()

摘要

主动推理提供了感知行为的第一原理描述,从中可以导出特殊和重要的案例,例如强化学习、主动学习、贝叶斯最优推理、贝叶斯最优设计等。主动推理通过将信息获得置于与奖励或价值相同的基础上,解决了与先前偏好相关的开发-探索困境。简而言之,主动推理以预期(变分)自由能的形式,用(贝叶斯)信念的泛函代替了价值函数。在本文中,我们考虑一种复杂的主动推理,使用预期自由能的递归形式。复杂性描述了一个代理对信念的信任程度。我们考虑对事态的行动的反事实后果有信念的代理人和对那些潜在状态有信念的代理人。换句话说,我们从简单地考虑“如果我做了那件事会发生什么”转变为“如果我做了那件事,我会相信发生什么”。自由能泛函的递归形式有效地实现了对未来行动和结果的深树搜索。至关重要的是,这种搜索是基于信念状态的序列,而不是状态本身。我们用深层决策问题的数值模拟来说明这种方案的能力。

关键词:主动推理;信念传播;贝叶斯最优性;贝叶斯决策理论;变分自由能;探索;剥削

can both ‘learn to plan’ and ‘plan to learn’.

节选内容共约7000字

介绍

在理论神经生物学中,主动推理已被证明有助于在理想贝叶斯假设下提供动机行为的一般解释,包括认知和实用价值(Da Costa等人,2020a弗里斯顿等人,2017年a)。这种解释通常被描述为基于第一原理,因为它继承了非平衡稳态下随机动力系统的统计物理学(Friston,2013;Hesp等人,2019a帕尔等人,2020年)。主动推理并没有假装取代现有的感知行为公式——它只是提供了一种贝叶斯机制,从这种机制中,大多数(也可以说是所有)规范优化方案都可以作为特例导出。一般来说,这些特殊情况是在忽略某种不确定性时出现的。例如,如果我们忽略产生(可观察到的)结果的(不可观察到的)隐藏状态的不确定性,主动推理就变成了传统的方案,如最优控制理论和强化学习。虽然后一种方案倾向于关注作为隐藏状态本身的函数的价值最大化,但主动推理优化了关于隐藏状态的(贝叶斯)信念的功能。这使得它能够以一种统一的、贝叶斯最优的方式来解释围绕行动和感知的不确定性。

主动推理的大多数当前应用依赖于策略的选择(即,有序的动作序列;或开环政策,其中未来行动的顺序仅取决于当前状态而不取决于未来状态),其最小化被称为期望自由能的信念泛函(Da Costa等人,2020a弗里斯顿等人,2017年a)。这种方法显然有局限性,因为人们必须指定一个先验的可允许的策略,每个策略代表一个可能的路径通过一个动作序列的深树。这种公式限制了后续方案的可扩展性,因为只能评估相对少量的策略(Tschantz等人,2019)。在本文中,我们考虑了主动推理方案,该方案能够在未来所有允许的动作序列上进行深度树搜索。因为这涉及到一个预期自由能的递归评估——和隐含的贝叶斯信念——产生的方案有一个复杂的方面(Costa-Gomes等人,2001;Devaine等人,2014);也就是说,推出关于信念的信念。

“Sophistication”是经济学文献中的一个术语,指的是对自己或他人的信念有信心。例如,在博弈论中,如果一个代理人对她的对手有信念,那么她被认为具有一级的复杂程度;如果她相信对手对她的策略的看法,那就是两个;诸如此类。大多数人的复杂程度高于2(camer et al .,2004)。

从这个角度来看,当前大多数关于主动推理的解释都被认为是不成熟或幼稚的,因为它们只考虑了关于行动结果的信念,而不是行动结果对信念的影响。在接下来的内容中,我们试图使用数学和数值分析,直观而正式地揭示这种区别。我们也借此机会调查现有的计划,属于积极推理的贝叶斯机制;包括期望效用理论(冯·诺依曼和摩根斯坦,1944)、贝叶斯决策理论(伯杰,2011)、最优贝叶斯设计(林德利,1956)、强化学习(萨顿和巴尔托,1981)、主动学习(麦凯,1992)、风险敏感控制(范登布鲁克等人,2010)、人工好奇心(施密德胡伯,2006)、内在动机(欧代尔和卡普兰,2007)、授权empowerment(克柳宾等人,2005)以及Tishby和Polani,2010年)。

(Friston等人,2017a)的附录6简要介绍了复杂推理和简单推理之间的基本区别。这种区别很微妙,但会导致完全不同的行为。我们将用一个简单的例子来说明不同之处:考虑下面的三臂强盗问题——有一个转折。左臂和右臂增加或减少您的奖金。然而,你不知道哪只胳膊是哪只。中央手臂不会影响您的赢款,但会告诉您哪只手臂会赢。至关重要的是,一旦你投入左臂或右臂,你就不能切换到另一只手臂。这个游戏被设计用来迷惑那些基于贝叶斯决策理论选择行为的代理人。这是因为每一步的预期收益都是一样的。换句话说,选择右臂或左臂——在第一次和随后的试验中——意味着你赢或输的可能性相等。类似地,选择中间臂(或者实际上什么都不做)具有相同的贝叶斯风险或预期效用。

然而,一个积极的推理代理人——她正试图最小化她的期望自由能2——将选择最小化失败风险的行动,并解决她关于左臂还是右臂有回报的不确定性。这意味着中心臂获得认知(解决不确定性)启示,并变得具有内在吸引力。在选择中央臂——并发现哪一个臂持有奖励——时,她随后的选择是知情的,从某种意义上说,她可以利用自己的知识并致力于奖励臂。在这个例子中,代理解决了一个简单的探索-利用困境3,通过解决模糊性作为利用关于后续行动结果的更新信念的前奏。请注意,选择了中央手臂,游戏中就没有模糊性,它的认知启示也消失了。进一步注意,最初,所有三个臂都有一些认知启示;然而,如果收益是概率性的,那么左臂和右臂提供的信息就少了。

这篇论文背后的关键步骤是考虑一个复杂的智能体,它递归地评估每个移动的期望自由能。简单地选择解决不确定性的核心部分,本身并不意味着选择了一种认知行为来确保未来的回报。换句话说,选择中心组是因为所有选项都有相同的贝叶斯风险4;而中央臂有最大的认知启示5。现在考虑一个老练的代理人,她想象她在表演后会做什么。对于每一个可能的结果,她可以计算出她对隐藏状态的信念将如何更新——并评估在每一个动作和后续结果下,后续移动的预期自由能。通过取两者的平均值,她可以计算出第一步所能提供的第二步的期望自由能。如果她递归地重复这个过程,她可以有效地对所有有序的动作序列及其结果进行深度树搜索。

试探性地,不老练的代理人简单地选择中心臂,因为他知道它将解决关于事件状态的不确定性。相反,老练的代理人在解决模糊性的过程中,会对随后的选择产生影响。在这种情况下,她知道如果她选择中间的手臂,只会发生两件事;右臂或左臂将被公开为放线臂。无论是哪种情况,接下来的选择都可以明确无误地最小化风险并确保她的回报。这些后续作用的平均预期自由能将令人满意地低,使得选择中心臂比其预期自由能更有吸引力。这意味着老练的代理人对自己的选择更有信心,因为她已经超越了形成关于行动后果的信念,考虑了行动对随后信念和(认知)行动的影响。本文的其余部分使用形式分析和模拟来解开这种递归类型的规划。

主动推理和自由能最小化

大多数主动推理文献关注的是部分可观测的马尔可夫决策过程。换句话说,它考虑了离散隐藏状态和可观察结果的生成模型,以及隐藏状态和结果之间的(可能性)映射和隐藏状态之间的(先验)概率转移的不确定性。至关重要的是,通过将动作序列(即策略)视为随机变量,顺序策略选择被视为推理问题。规划只需要优化对所追求政策的后验信念——并从最有可能的政策中选择一项行动。

从这个角度来看,只有两组未知变量:即隐藏状态和策略。然后,可以使用适当的平均场近似法,以通常的方式相对于证据界限来优化这种二分的置信分布(Beal,2003;温和毕晓普,2005年)。在这种设置中,我们可以将感知与关于隐藏状态的后验信念的优化相关联,而行动则来自基于关于政策的后验信念的规划。这个公式隐含着一个生成模型;也就是说,政策(即行动策略police)、隐藏状态和结果的联合概率分布的概率规范。

这种生成模型通常被分解成给定隐藏状态、隐藏状态上的条件分布、给定策略和策略上的先验的结果的可能性。在主动推理中,策略的先验是由它们的期望自由能决定的,注意,依赖于未来行动过程的期望自由能提供了对后续行动的经验先验

f未来隐藏状态之间的预期相互信息及其后果——与最小冗余或最大效率原则一致(巴洛,1961;巴洛,1974;Linsker,1990)。最后,从统计学的角度来看,最大化内在价值(即显著性和新颖性)对应于最优贝叶斯设计(Lindley,1956)和机器学习衍生物,如主动学习(MacKay,1992)。根据这一观点,主动学习是由新奇感驱动的;即,在给定未来状态及其结果的情况下,提供给关于模型参数的信念的信息增益。启发性地,这种好奇心解决了“如果我那样做会发生什么?”的不确定性(Schmidhuber,2010年)。Figure 1 说明了预期自由能的指南针,就其特殊情况而言,从最优贝叶斯设计到贝叶斯决策理论。

复杂的推理

到目前为止,我们已经考虑了政策的生成模型;即固定数量的有序动作序列。这些生成模型可被视为优先于规定少量可允许的动作序列的动作。在下文中,我们考虑更一般的模型,其中随机变量是每个时间点的行为;使得策略优先于动作或控制状态之间的转换。如果我们放松这种先验,让后续行动有条件地独立,我们可以简化信念更新——以及隐含规划——代价是必须考虑潜在的大量政策。

由于动作和状态都变成了马尔可夫的,所以通过假设动作是有条件独立的来提供简化。这意味着我们可以使用信念传播(Winn和Bishop,2005;Yedidia et al .,2005)更新关于隐藏状态和动作的后验信念,给出每个新的观察结果。换句话说,我们不再需要评估过去隐藏状态的后验来评估政策的后验。从技术上来说,这是因为政策通过诱导过去和未来隐藏状态之间的条件依赖,引入了信念更新的半马尔可夫方面。其结果是,人们可以使用来自前一时间步的后验信念作为隐藏状态和动作的经验先验

在随后的时间步。这在形式上相当于前向-后向算法中的前向传递(Ghahramani和Jordan,1997),其中隐藏状态上的经验先验取决于前面(即实现的)动作。简而言之,我们正在实现一个贝叶斯过滤方案,在这个方案中,观察是由每个时间步的动作生成的。关键的是,下一个动作是从基于关于当前隐藏状态的后验信念(的自由能函数)的经验先验中采样的。

该方案是精确的,因为我们没有进行变分信息传递所需的平均场近似(Dauwels,2007;弗里斯顿等人,2017c帕尔等人,2019;温和毕晓普,2005年)。此外,没有对政策的有条件的依赖,政策已经被实现的行动所取代。然而,等式(1.10)只考虑下一个动作。现在的问题是:我们应该考虑多少未来的行动?

在这一点上,马尔可夫假设的成本出现了:如果我们选择一个太遥远的政策范围,政策的数量可能是巨大的。换句话说,我们可以有效地对所有可能的未来动作序列进行深度树搜索,这在计算上是禁止的。然而,我们现在可以转向复杂的方案来精细组合学。这是基于一个简单的观察:如果我们传播信念和未来的不确定性,我们只需要评估有很大可能性被推行的政策或路径。这种对合理路径的选择性搜索受到两个层面的限制。首先,通过传播概率分布,我们可以将搜索限制在具有非平凡后验概率(例如,大于1/16)的未来结果上——对于未来任何点的任何给定行为。同样,我们只需要评估那些有可能推行的政策;也就是说,那些具有使它们的先验概率不平凡(例如,大于1/16)的预期自由能。

这种深度搜索包括评估所有可能结果下的所有行动,以便人们可以在每个时间点(给定所有可能结果)执行反事实信念更新。然而,没有必要评估结果本身——评估结果的分布就足够了,以可信的隐藏状态为条件。这是巧妙运用信念传播到未来的组合学的一个微妙但重要的方面——这取决于有一个生成模型(生成结果)。

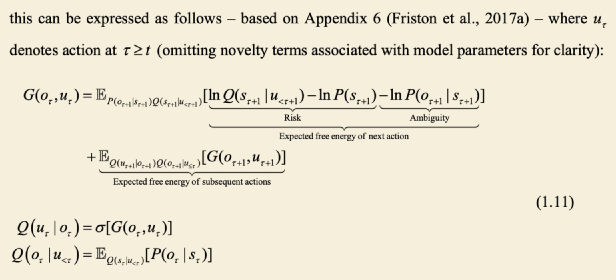

启发式地,人们可以想象在未来的连续时间搜索具有分叉分支的树,但是当行动的先验概率(及其后续结果的预测后验概率)达到适当小的阈值时,终止沿着任何给定分支的搜索(Keramati等人,2016;Solway和Botvinick,2015)。为了形成下一个动作的边缘经验先验,简单地递归累加来自树中给定节点的所有子节点的平均期望自由能。然后,该累积平均值的softmax函数构成下一个动作的经验先验。从算法上来说,这可以表示如下——基于附录6 (Friston等人,2017 a)

然后,隐藏状态的后验信念和行动的经验先验从上述递归中恢复如下,注意,一个人的最近行动(ut1)和当前结果(ot)是实现的(即,已知的)变量:

等式(1.11)将每个潜在的下一个行动(u)的预期自由能表示为在反事实结果和行动(u 1)下,该行动的风险和模糊性加上未来信念的平均预期自由能。熟悉贝尔曼最优的读者

原则(贝尔曼,1952年)可能承认(1.11)和贝尔曼之间的形式相似性

等式,因为两者都继承自相同的递归逻辑。复杂的推理方案处理泛函(状态上的信念分布函数),而贝尔曼方程直接处理状态函数。

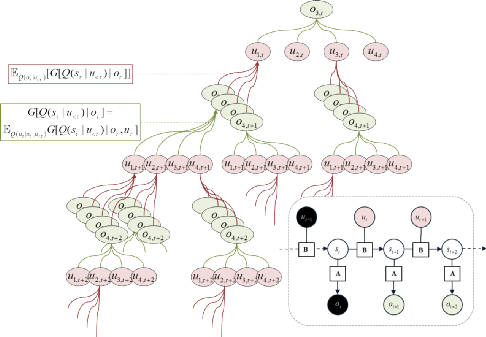

Figure 2 提供了将此递归公式转换为深度树搜索的示意图。这种搜索可以在任何深度或地平线上终止。稍后,我们将根据足够的统计数据重写这个递归方案,以说明它的简单性。就信念传播而言,已经建立了复杂计划的正式基础,我们现在转向一些说明性的例子来展示它在实践中是如何工作的。

图2

深度策略搜索。这个示意图总结了未来路径或轨迹上预期自由能的积累。这可以被解释为深度树搜索,其中树分支在每个时间点的可允许的行为——以及每个行为可能导致的结果。行动和结果之间的箭头以相反的方向画出(指向未来),以描述行动的预期自由能的平均值(绿色箭头)和前一行动导致的结果的平均值(粉色箭头)。这种对行动(给定结果)和结果(给定行动)的双重平均由上图中的等式描述。这里,这个树的绿色节点对应于结果,在当前时间有一个(实现的)结果(在顶部)。粉色节点表示动作;在这里,只有四个。请注意,只要某个行动被认为不太可能,或者某个结果不可信,搜索就会终止。右下方的面板将创成式模型中的条件从属关系表示为概率图形模型。这个模型的参数显示在方块上,而变量显示在圆圈上。箭头表示条件依赖。实心圆是当前时间的实际变量;即前面的动作和后面的结果。

深度规划和导航

上面的模拟表明,一个复杂的信念更新方案能够使政策选择更加自信和细致——这转化为更有效的剥削行为。为了说明这种方案如何扩展到更深层次的策略搜索,我们基于拉普拉斯图(Kaplan和Friston,2018年)重新考察了之前使用定制先验解决的问题。这个问题以前是按照在迷宫中导航到目标位置来设计的。这里,我们放弃任何特殊的先验知识,看看这个复杂的方案是否能够处理支持矛盾行为的深度树搜索,

比如远离一个目标,然后再去保护它(参见山地汽车问题)。至关重要的是,在这种情况下,隐藏状态没有模糊性。然而,关于确定特定位置是否应该被占用的可能性映射存在模糊性或不确定性。换句话说,这个例子使用了更传统的觅食设置;其中大鼠必须了解迷宫的结构,同时,追寻其先前的偏好以到达目标位置。在这里,探索性行为是由内在价值或信息增益驱动的,这些价值或信息增益赋予了对似然模型参数的信念——与隐藏状态相反。通俗地说,人们可以认为这是认知启示,由新颖性而不是突出性来保证(巴尔托等人,2013;帕尔和弗里斯顿,2019年a;Schwartenbeck等人,2019)。话虽如此,我们预计完全相同的行为将会出现,复杂的方案将能够计划学习,然后利用它所学到的东西。

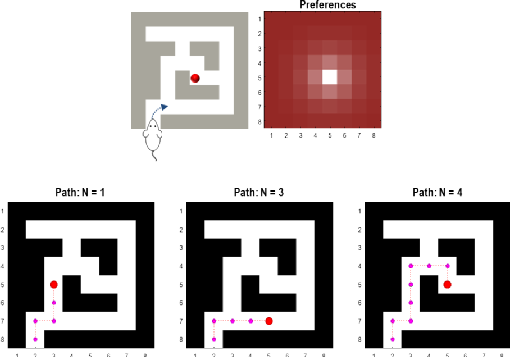

在这个范例中,大鼠必须通过88网格迷宫,其中每个位置可能会或可能不会传递轻微的厌恶刺激(例如,脚电击)。导航是由占据目标位置的先前偏好所激发的;这里,中心。在下面的模拟中,老鼠从迷宫的入口处开始,优先选择安全的结果(代价为-1)和厌恶的结果(代价为+1)。位置的优先选择取决于从当前位置到目标位置的距离。这种设置的生成模型很简单:有一个隐藏因子,它有64个状态,对应于所有可能的位置。这些隐藏的状态会产生安全或厌恶(身体感觉)的结果,这取决于位置。此外,还会生成直接报告网格位置的(外部感受)提示。五个允许的动作包括向任何方向迈出一步或原地不动。

图5

作为推理的导航。该图报告了模拟迷宫导航的结果。上图展示了这个迷宫的形状,它包括一个8 x 8的网格。每个位置可能会也可能不会产生轻微的不良后果(如脚震)。同时,老鼠的优先选择是靠近迷宫的中心。这些优先选项以图像格式显示在右上面板中,其中日志优先选项以粉红色显示,白色是最优先的位置。下面的三个面板记录了老鼠从左下方的起始位置开始的轨迹或路径。三个面板显示了一个、三个和四个计划跨度的(确定性)解决方案。当视野小于4时,老鼠会被困在最靠近中心(即目标)位置的厌恶屏障的另一侧。这是因为任何离开这个位置的运动——一个小的偏移——比留在原地具有更小的预期自由能。然而,如果策略搜索足够深入(即,规划范围大于三),则rat可以有效地想象如果它深入到未来会发生什么;使得长期收益能够超过短期损失。这导致rat推断并追踪到达目标位置的最短路径;尽管它偶尔会偏离中心。在这些模拟中,老鼠知道厌恶结果的位置,并被最小化贝叶斯风险所激励。

Figure 5 显示了将计划跨度从一个增加到四个时的典型模拟结果。这里要观察的关键是,有一个临界视界,使得我们的主体在追求目标时,能够避开预期自由能的局部最小值。在这些模拟中,我们的受试者对厌恶的地点有充分的了解,并简单地计划了一条到达目标地点的路线。然而,相对简单的代理会被卡住

离目标位置最近的厌恶障碍的另一边。换句话说,他们留在期望离开的自由能总是大于留在原地的位置(Cohen等人,2007)。当规划范围不足以让大鼠考虑远端(和潜在更好的)结果时,就会发生这种情况(如左下和中间的图所示Figure 5).然而,当规划范围为4(或更多)时,这些局部最小值就失效了,rat很容易规划——并执行——到达目标的最短路径。在这些模拟中,总共移动了八次,这足以通过最短的路径到达目标。这种行为让人想起解决山地汽车问题等问题所需的前瞻性规划。换句话说,最小期望自由能的路径通常涉及偏离最终目标的状态(和信念)空间。

结论

本文描述了一个期望自由能的递归公式,它有效地激发了作为推理的规划的深树搜索。接下来的计划是复杂的,从某种意义上来说,它包含了对信念的信念——通过积累对预期自由能的可预测的后验预期,沿着看似合理的路径。换句话说,不是仅仅传播关于连续行为结果的信念,该方案基于先前关于行为结果的信念来模拟未来的信念更新。这个方案是用一个简单的T型迷宫问题和一个需要更深入搜索的导航问题来说明的。

在引言中,我们注意到主动推理可能难以扩展,尽管最近在这个方向上使用摊销推理和抽样已经取得了显著的进展。例如,(ueltzhffer,2018年)使用函数逼近器对生成模型和近似后验模型进行参数化——当梯度

可用时,使用进化方案来最小化变化的自由能。类似地,(Millidge,2019)通过学习预期自由能的参数化近似值,摊销了感知和行动。(Catal等人,2019年)使用从实例中学习的方法,专注于学习先前的偏好。(Tschantz等人,2019年)扩展了之前的点估计模型,以包括参数的完整分布。这使他们能够将主动推理应用于连续控制问题(例如,山地汽车问题、倒立摆任务和具有挑战性的漏斗任务),并证明相对于强大的无模型基线,采样效率提高了一个数量级(Lillicrap等人,2015年)。请参见(Tschantz等人,2019年)的全面讨论——以及对主动推理的有益解构,与基于模型的强化学习等事情有关;例如(Schrittwieser等人,2019年)。

请注意,导航示例是计划学习的一个实例。因此,它解决了强化学习及其变体通常解决的问题。换句话说,我们能够从第一原理(即变分原理)解决学习问题,而无需求助于逆向归纳法或其他(无信念)方案,如Q学习、SARSA或后继表征;例如(达扬,1993;格什曼,2017;Momennejad等人,2017;Russek等人,2017年)。这具有潜在的重要意义,因为根据推理(而不是学习)预测优化方案赋予了它一种上下文敏感性,这是许多学习算法无法做到的(Daw et al .,2011)。换句话说,因为存在时间敏感的隐藏状态的概率表示(以及关于那些状态的隐含不确定性),

行为的动机是解决一个代理人操作的环境的不确定性。这可能是一种(贝叶斯)机制,它允许既能“学会计划”又能“计划学习”的有能力的计划的概念。

主动推理的当前公式不需要采样或矩阵求逆——贝叶斯最优信念更新以确定性的方式处理不确定性。从概念上讲,这反映了随机动力系统的随机方面与伴随的密度动力学的确定性行为之间的差异,后者描述了这些系统的概率演化(例如,福克普朗克方程)。因为主动推理在信念空间中起作用,即在统计流形上(Da Costa等人,2020b)。不需要采样或随机搜索,而是通过将信念或概率分布传播到未来来评估最佳路径,以找到变化最小的自由能路径(Friston,2013)。

在深度策略搜索的设置中,这种方法具有在特定路径变得不可信时终止搜索的实际优势。例如,在上面的导航示例中,有五个动作和64个隐藏状态,导致大量的潜在路径(对于四个规划范围为1.0486×1010,对于六个规划范围为1.0737×1015)。然而,这些路径中只有极小一部分被实际评估——通常是几百条,在个人计算机上需要几百毫秒。给定关于当前状态和状态转换的相当精确的信念,只有少量的路径有资格评估,这导致我们对主动推理的可伸缩性的最后评论。

完整内容请参考原论文