原文链接:https://mp.weixin.qq.com/s/ig96D1kNCUlVITqEYSgUlA

来源:AI科技评论

作者:Sepp Hochreiter

解读:Antonio

编辑:陈彩娴

人类包含意识、认知、决策等等在内的智慧能力,似乎从人类有记录的那一刻起,就吸引着无数哲学家的思索。与之类似,从AI诞生的那一刻,科学家们则在憧憬:AI 如何能够达到像人类一样的智能?

近期,LSTM 提出者和奠基者,奥地利人工智能高级研究所(IARAI)创始人,曾获得IEEE CIS 2021 年神经网络先驱奖(Neural Networks Pioneer Award)的Sepp Hochreiter教授在《ACM通讯》上对目前AI达到的智能水平发表了看法。

Sepp Hochreiter 指出,目前 AI 的发展正以广义 AI(Broad AI)为目标。他强调,将以往基于逻辑的符号AI和现有的基于数据的神经AI结合的双向AI(bilateral AI)是最有希望实现广义 AI 的方式。

1

现有神经网络的不足

深度神经网络是现在 AI 的主流实现方式。尽管它可以实现惊人的性能,但就和人的智能比较而言,它仍然存在很多的缺陷。Hochreiter 教授援引纽约大学认知科学家 Gary Marcus 曾经对于神经网络的批判,认为:(1)神经网络极度需要数据(data hungry);(2)有限的迁移能力、也无法有效地迁移到新的任务或者数据分布上去;(3)对于世界知识或者先验知识无法充分地融合进去。

也因此,Hochreiter教授警示道,决策者对于这些模型在真实数据的应用领域的效果存疑,因为真实场景下的数据总是变化着的、带噪声的、甚至数据稀缺的。事实上,在需求很大但安全性和可解释性占很大考量的医疗、航空、无人驾驶等领域,深度学习技术的应用仍旧有限。

2

“Broad AI”

尽管如此,Hochreiter教授也指出,当下的 AI 已经在试图克服这些缺陷,并且以“广义AI”(broad AI)作为当下AI的新目标。

什么样的系统是广义AI呢?

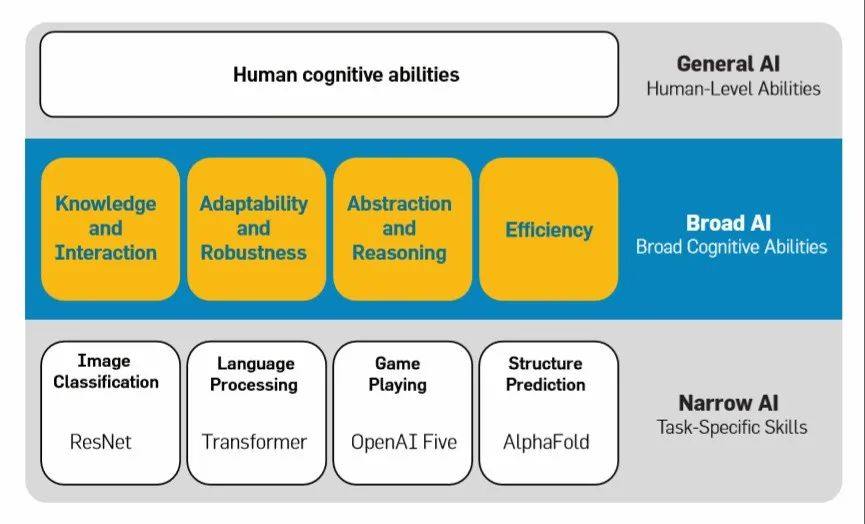

它区别于现有的、专门针对特定任务设计的狭义AI(narrow AI),而更加强调技能习得和问题解决的能力(skill acquisition and problem solving)。这一观点来自任职于Google、Keras作者François Chollet曾在一篇论文中提到对于智能的定义。Chollet认为处于智能第二阶梯(下图)的广义AI应该具有以下重要的特征:知识迁移和互动、鲁棒性、抽象和推理的能力、高效性。而广义AI充分利用感知与料(sensory perception)、以往经验和学习到的技能成功胜任不同的任务。

图注:不同层次的AI对应的能力

Hochreiter教授认为现有的架构、网络或者方法在一定程度上是达到了Broad AI的要求的。他列举了使用对比学习进行自监督训练的学习方式来表明迁移性;充分利用上下文和以往经验的Modern Hopfield networks;以及融合了知识和推理的神经-符号计算模型。

3

迁移性

现有的可以有效提高网络迁移性的模型学习方式莫过于小样本学习。它仅仅使用少量的训练数据就可以取得不错的性能。而这要归功于它已有的“先验知识”或者“经验”。这些先验知识往往得益于预训练任务——包含大规模的数据和基础模型(foundation model)。而这样数据往往是通过对比学习、自监督训练的方式进行提取有用的表征。一旦预训练模型学好之后,该任务上习得的后验知识变成下游新的任务的先验知识,使得模型很好地迁移到新的情境、顾客、产品、流程、数据等上面。

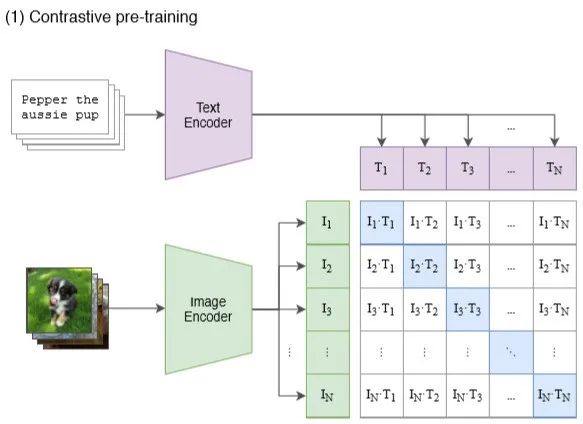

Hochreiter教授特别提到了在视觉-语言跨模态领域的对比学习预训练方法——CLIP。CLIP是OpenAI去年发表在ICML上的一项工作,它使用一个简单的预训练任务,即图文匹配,通过对比学习的方式来学习更为强大的图像表征。该任务使用了4千万从网上收集来的图文对来进行训练。

图注:CLIP利用图文匹配的方式进行训练

意料之中的惊讶在于,它之后无需任何数据训练就可以在30多个计算机视觉任务上实现和之前全监督的方式可比的性能,实现了卓越的“零样本学习”。而正如 Hochreiter 教授所称赞,这种高度的迁移性和鲁棒性是部署在拥有真实数据的工业界十分青睐的特点。

事实上,自从CLIP发明之后,后续很多迁移学习的工作都是基于CLIP的。不夸张地说,它绝对是视觉语言统一的不可或缺的一环,有些类似于 Bert 之于 NLP 任务。而现今流行的 Prompt learning(提示学习)的方法很多也在借鉴 CLIP,或者在CLIP的框架下。

4

利用经验

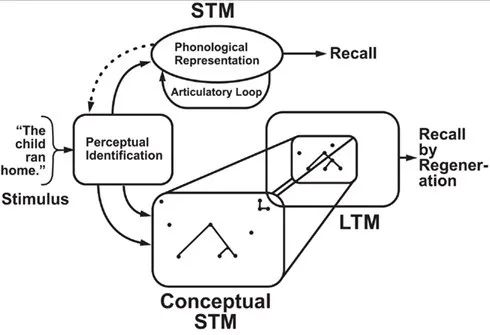

广义 AI 还应充分利用上下文环境和以往的经验,这和记忆息息相关。这一点或许Hochreiter教授有很好的发言权,他毕竟是长短时记忆网络的发明者之一。而在认知科学中,有学者曾经提出过概念短时记忆,它描述的是当人类在接受到一个刺激时候,比如一幅图、一个单词,他会快速地将这些刺激转化到一个抽象的概念范畴,并把它关联到和长时记忆相关的信息。“刺激-概念化-关联”这个过程几乎是无意识地发生,但对于我们理解日常事物、语言交流有着非常重要的作用。

图注:“刺激-概念化-关联”的认知过程

关于这一点,Hochreiter列举了Modern Hopfield networks(MHN)的工作,事实上这篇工作也在他本人的指导下完成的。Hopfield神经网络早在1982年就被提出,它是一种结合存储系统和二元系统的神经网络,模拟了人类记忆的模型。MHN认为Transformer中的自注意力机制是带有连续状态的Hopfield网络的一种更新规则,并且从Hopfield网络的角度对自注意力做了新的解释。其中和记忆相关的一部分解释在于它挖掘了数据中的相关性结构(covariance structure),即如何使特征同时出现在数据中。MHN会放大这种共现。这种相关性可以被认为是触发了记忆中的关联部分,从而有效地利用了已有的知识。

Hochreiter指出,MHN可以发掘丰富的数据间的相关关系,这一优势可以避免当代方法容易遭遇的“捷径学习”(shot-cut learning)的风险。“捷径学习”是指模型学习到的并非真正用于决策的“特征”,而只是找到了一些特殊的相关性,如飞机总是出现在图片的上半部分等。(详情参考AI科技评论过往介绍:深度学习败于“捷径”)

5

神经-符号系统结合

神经网络与符号系统能够更好地促进 AI 模型对世界知识与抽象推理等能力的融合。

基于理性主义的符号系统立足于逻辑和符号表征,直接将人类的推理方式编码到机器中,它的优势在于抽象能力强大、使用较少的数据就可以达到比较好的结果。不过受限于现实世界知识的复杂多样以及非结构化,很难将这些完美无缺地编码到机器可读的规则中。

而基于经验主义的神经网络直接利用大量的数据,通过隐式(无监督)或者显式(监督)地指导模型学习到数据有用的表征,无需设计复杂的规则,就可以达到惊异的性能。不过,神经网络也面临着解释性弱、数据饥饿等难题。

将二者有机地结合也是AI领域学者经常思考的一个问题。有趣的是,这也可以联想到人类历史的观念之争中,理性主义和感性主义的此消彼长同样是一个争议性的话题。

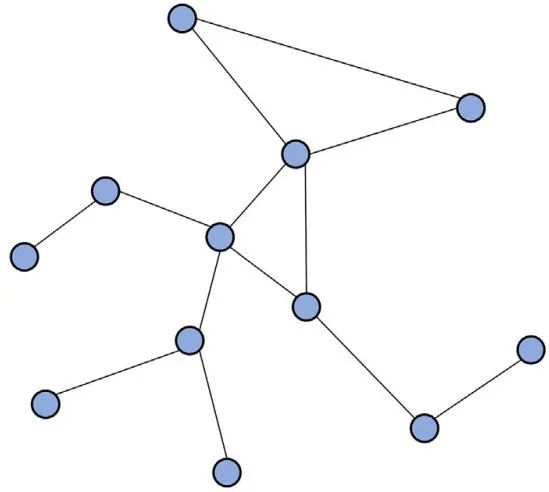

Hochreiter教授则认为已经发展了一段时间的图神经网络(GNN)是这一方向的代表。这也是来自发表在IJCAI’20上的一篇调查的意见,它将GNN归类为类型1的神经-符号系统。文章认为二者都有如下共同之处:都在寻求神经网络输入的丰富的向量化表示;都采用了一种树和图的结构去表征数据和它们之间的关系。Hochreiter教授认为它们在分子属性、社交网络建模、工程领域的预测等等强调动态交互和推理领域都有很好的表现。

图注:GNN图结构示意图

6

总结

Hochreiter强调,实现广义AI需要神经-符号系统的结合,以达到一种双向AI(bilateral AI)。而AI研究者也应该朝着具有更强的技能习得和问题解决能力的AI系统努力。他还展望道,欧洲在这两方面都有传统的优势,因而要利用这些优势,积极地寻求广义AI的解决方案。

参考资料:

Hochreiter, Sepp. "Toward a broad AI." Communications of the ACM 65.4 (2022): 56-57.

Chollet, F. On the Measure of Intelligence (2019); ArXiv:1911.01547.

Luís C. Lamb, Artur d'Avila Garcez, Marco Gori, Marcelo O.R. Prates, Pedro H.C. Avelar, and Moshe Y. Vardi. 2021. Graph neural networks meet neural-symbolic computing: a survey and perspective. In IJCAI'20. Article 679, 4877–4884.