原文链接:https://mp.weixin.qq.com/s/OjG7VQwAm6GjJYxnbZvRkg

人工智能学家

来源:ScienceAI

编译:绿萝

「了解大脑的所有复杂性需要从多个尺度——从基因组学、细胞和突触到整个器官水平的洞察力。这意味着处理大量数据,超级计算正在成为解决大脑问题的不可或缺的工具。」人类大脑项目 (HBP) 科学主任、杜塞尔多夫大学和 Jülich 研究中心神经科学与医学研究所 (INM-1) 主任 Katrin Amunts 说。

Katrin Amunts 和 Thomas Lippert 在《Science》发表「Brain research challenges supercomputing」为题的观点论文。

人类大脑包含约 860 亿个神经元。放大其细胞和亚细胞细节,揭示神经元连接的不同方面,是一个重要的研究领域。然而,将突触水平(纳米范围)到单个神经元和神经胶质细胞(微米水平)的不同空间尺度连接到整个器官是最具挑战性的。最近,秀丽隐杆线虫的连接组具有 302 个神经元的特征,并提出了完整的结构功能模型。人类大脑连接组的类似细节水平还有很长的路要走。因此,解码人类连接组、信号转导机制以及与大脑功能的关系,与先进计算和存储技术中呈指数增长的挑战有关,这反过来可能会导致神经科学之外的创造性解决方案。

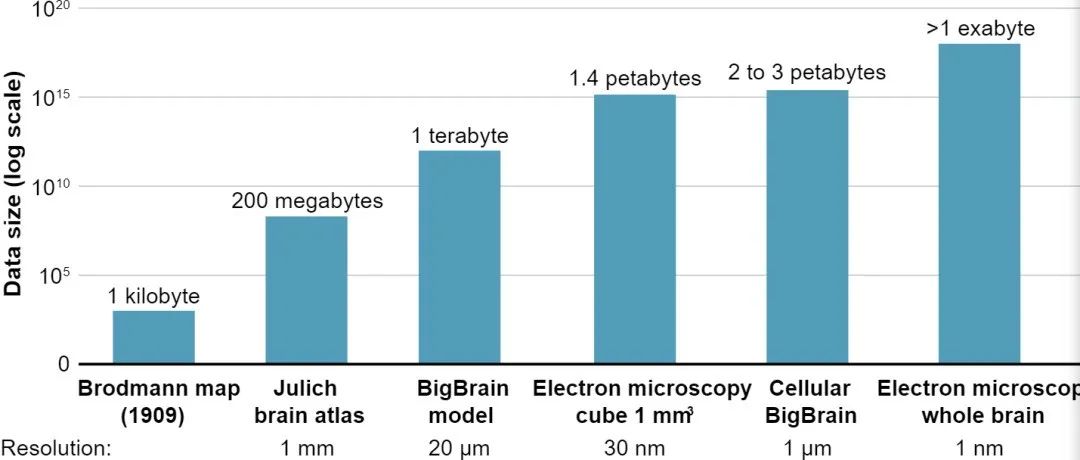

扫描时间、存储技术和数据处理的挑战并非始于人类大脑的研究,而是研究脊椎动物甚至无脊椎动物的大脑时的重要考虑因素(见图)。例如,重建具有约 100,000 个神经元的成年果蝇大脑的突触连接,最终生成了约 2100 万个相机图像和 106 TB 的数据集。最近,人类大脑皮层的一个片段,大约 1 平方毫米的体积,在三个维度上被重建,对应于大约 1.4 PB 的数据量。虽然 1 mm^3 是大脑皮层的一小部分,占大脑总体积的 0.00007%,但需要高速多光束电子显微镜以 326 天的扫描时间收集这些数据。进行此类研究的动机是,深入了解大脑的详细结构可能会揭示对皮层网络的新理解,并提供描述组织特性的新定量数据,并对大脑活动产生影响。

来自人脑研究的大数据根据对人脑连接组和组织的研究的分辨率,数据的大小呈指数增长。最大的两个条形是估计大小,因为人类大脑不存在此类数据。

这种对人脑组织的分析是对其他物种大脑研究的重要补充,因为它们之间存在相当大的差异,尤其是连通性。例如,在哺乳动物进化过程中,大脑皮层的白质体积比灰质(含有神经元细胞体)增加得更快,其中包含支持远程连接的轴突。长短连接的比例对电生理特性有影响,因此对大脑功能有影响。然而,与啮齿动物或无脊椎动物相比,研究人类大脑中轴突及其突触的全部范围(可能距离它们的细胞体几厘米)代表了一个更实质的问题。

磁共振成像(MRI)能够解决远距离连接并揭示连接模式,包括活人大脑中的功能连接,但图像体素在毫米范围内。该分辨率远低于检测单个轴突所需的空间分辨率,因此容易导致束重建中固有的歧义。此外,大脑连通性包括诸如侧支化(一个轴突可能针对多个区域)、收敛、互惠或空间分离的「树突乔木」等现象,这些现象被认为是理解连通性的关键,但无法通过 MRI 获得。

因此,宏观和微观连接组尺度之间存在差异。已经提出了不同的方法来弥合这两个世界:例如,最近在同一组织块中探索了使用 CLARITY 技术清除的脑组织中荧光标记神经丝的扩散 MRI 和高分辨率光学成像的组合,以允许更强大多模态 MRI-CLARITY 比较。在另一项研究中,来自人类海马的组织块通过解剖和扩散 MRI、三维偏振光成像 [3D-PLI; (11)] 和双光子荧光显微镜将不同空间尺度的海马纤维结构信息汇总在一起,并将其表示在一个共同的参考空间 BigBrain 模型 (www.ebrains.eu) 中。这些数据显示了穿孔通路,它不代表一个统一的管道,而是一个多组分系统,起源于内嗅皮层,具有许多细轴突纤维束(在 20 毫米的范围内)并投射到角部和下叶。3D-PLI 是一种显微技术,可以解码穿孔通路的精细结构,该通路在学习和记忆以及阿尔茨海默病的发病机制中具有核心作用。在方法论上,不同技术的组合有助于交叉验证结果。实际上,它为将高分辨率感兴趣区域分析与全脑研究相结合铺平了道路。

Atlas 方法可以系统地充当宏观和微观尺度的桥梁,将来自单细胞超高分辨率研究的数据及其与感兴趣的小区域的联系整合到一个共同的微观参考空间中。BigBrain 以 20 毫米各向同性分辨率表示这种解剖模型,该分辨率略高于查看细胞形态细节所需的分辨率。它基于 7404 个组织学、细胞体染色切片;原始数据集约为 1 TB。BigBrain 提供了一个模板,将皮层甚至子层的发现与全脑结构、连接性和功能的数据相结合。

以细胞分辨率处理和分析整个人类大脑是一项巨大的挑战。目前,在全脑水平上深入到单个轴突还遥不可及。然而,为了简单起见,假设一个轴突连接两个神经元,在全脑水平跟踪轴突在计算上意味着什么?根据死后大脑的扩散 MRI 在毫米范围内计算全脑水平的纤维路线,意味着优化 4 × 10^5 个旋转方向。这将需要大约 130 兆字节的存储空间和 1 天的台式计算机计算时间。

使用 3D-PLI 对整个人脑进行 60 µm 各向同性分辨率水平的轴突分析将需要 8.3 TB 的存储空间和现有超级计算机上的数天时间来优化 2 × 10^10 个自旋。如此大的数据集也给数据可视化带来了巨大的挑战。例如,基于开源软件 VTK (www.paraview.org) 的 Paraview 可以使用并行图形处理单元 (GPU),并已应用于渲染和可视化 3D-PLI 数据。进一步优化 3D-PLI 以 1.3 µm 面内分辨率(即单轴突)获得的纤维取向,旋转 10^13 次,将导致 3.2 PB 的存储需求和多年的计算。这在目前的千万亿级技术中是不可能的,但可以通过未来的百亿亿级计算能力来实现,即每秒能够执行 10^18 次浮点运算(即 1 亿亿次浮点运算)的计算机。然而,处理如此大的数据集会在输入输出级别产生大量计算需求。更高效的输入输出程序和算法正在出现,这应该会有所帮助,但计算挑战仍然非常高。

当细胞和轴突信息与大脑组织的其他维度相关联时,计算要求也会进一步增加,例如,分子结构具有区域特异性,并且是信号转导的关键。同样,当添加时间变化来模拟细胞活动、可塑性或网络功能时,要求会进一步增加。在开发更符合生物学的大脑模型时,不仅要考虑大脑的区域隔离,还要考虑层流和亚层流特征及其特定的细胞数量、解剖和生理特性以及分布。同样,基于更现实的模型的人脑计算机模拟必须相应地缩放,这些模型解释了解剖学和生理学的限制。

这些努力对高性能计算技术提出了要求。例如,神经科学用例变得依赖于可扩展的工作流程,从提取存储在数据存储库中的多模态数据集到预处理、模拟、可视化和分析,甚至更多地使用机器学习和深度学习。此类工作流组件的计算将受益于未来超级计算的模块化和交互式概念,例如在欧洲深度项目中开发的那些概念。在模块化超级计算架构中,专门的计算模块被集成以形成深度连接的硬件架构,并且可以与最适合工作流特定组件的每个模块连贯使用。这包括各种模块,如中央处理单元 (CPU) 集群、GPU 增强器、用于数据分析的现场可编程门阵列模块、神经形态系统、极限存储模块,以及未来的量子计算机和退火器。此外,对需要交互式超级计算的神经科学工作流程的需求不断增长——例如,在继续之前可视化中间结果和正确的参数设置——并且依赖于 Paraview 等软件的交互式使用。

神经科学中的大数据挑战需要技术解决方案来存储数据(TB 到 PB 范围内),同时通过云提供给更广泛的社区。这需要从面向对象的云存储系统到超级计算机的 EB 级并行文件系统的透明数据传输。

艾伦大脑研究所为神经科学家提供了一个平台,并提供了大量反映不同物种(包括果蝇、斑马鱼、小鼠和人类)大脑组织多个方面的图像堆栈,以及用于可视化、上传和下载的工具(BigNeuron;www.alleninstitute.org/bigneuron/data/)。人类生物分子图谱计划旨在开发一个开放的全球平台来绘制整个人体中的健康细胞,这项努力伴随着大量的大数据和计算挑战。在欧洲,人类大脑项目开发了 EBRAINS 以提供大量研究仪器、数据和相关服务——重点是人类、大鼠和小鼠的大脑——它们相互关联,并使云访问交互式超级计算、基于网络的可视化和分析,以及通过 Fenix 的高端模拟和数据服务。该平台由神经科学家和开发人员根据研究需求共同构建,例如运行大规模模拟或 3D 重建和分析大脑模型。Fenix 被设计为一个通用的基础设施即服务平台,包括欧洲范围的身份验证服务,以支持许多研究社区的访问。在神经科学界共享数据、方法和研究工具,并在不同社区之间联合服务可以利用大量相关的方法和资源投资,这反过来又是开发新的脑医学诊断工具和疗法的基础。毫无疑问,基于云的超级计算和分布式协作研究平台,将在神经科学研究中发挥越来越大的作用,以更好地了解大脑的复杂性。

在未来五年内,欧洲的目标是部署其前两台百亿亿级超级计算机。它们将由欧洲高性能计算联合企业 (EuroHPC JU) 收购,这是欧盟、欧洲国家和私人合作伙伴之间的一项联合倡议。「大脑研究界随时准备使用这些百亿亿级系统。」Amunts 说。

参考内容:https://www.eurekalert.org/news-releases/935941

论文链接:

https://www.science.org/doi/10.1126/science.abl8519